Генеральный директор издательства игр опроверг гипотетический разговор о контроле за сотрудниками с помощью искусственного интеллекта, утверждая, что они не используют никакие инструменты для управления персоналом.

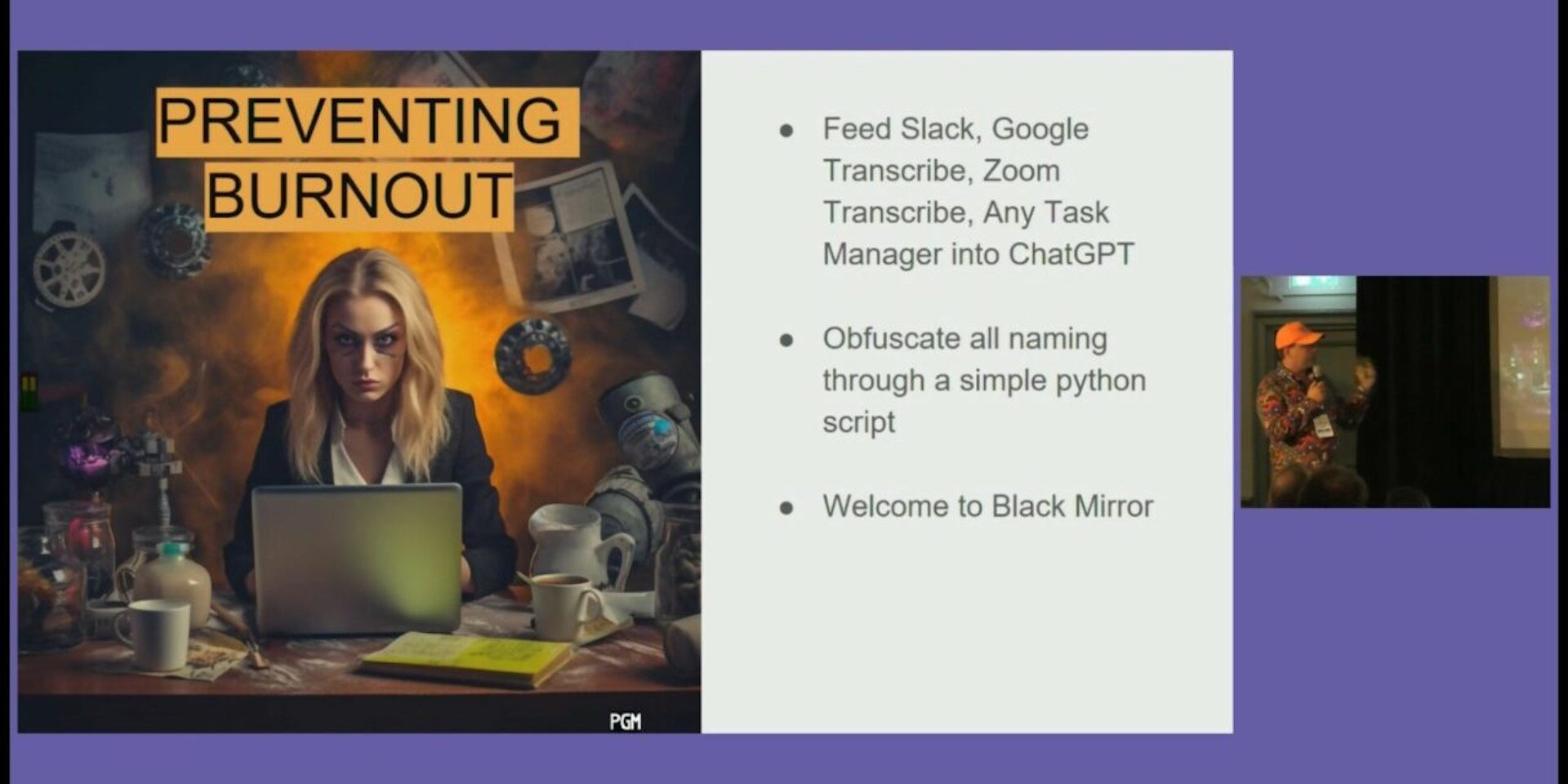

Генеральный директор Tinybuild Алекс Ничипорчик разворошил осиное гнездо на недавней презентации Develop Brighton, когда, как ему показалось, намекнул, что компания использует искусственный интеллект для мониторинга своих сотрудников, чтобы определить, кто из них токсичен или страдает от выгорания, а затем принять с ними соответствующие меры. Впоследствии Ничипорчик заявил, что его выступление в Интернете было вырвано из контекста, и что он описывал гипотетические сценарии, призванные проиллюстрировать потенциальные хорошие и плохие варианты использования искусственного интеллекта.

Как сообщает Whynow Gaming, в ходе презентации Ничипорчик заявил, что общение сотрудников через такие онлайн-каналы, как Slack и Google Meet, может быть обработано с помощью ChatGPT в рамках так называемого «I, Me Analysis», который ищет количество раз, когда сотрудник использует эти слова в разговоре.

(Image credit: Tinybuild (Develop: Brighton))

Существует прямая зависимость между тем, сколько раз человек использует «я» или «мне» на совещании, по сравнению с количеством слов, которые он использует в целом, и вероятностью того, что этот человек перегорит», — сказал Ничипорчик во время своего выступления.

Аналогичные замечания он сделал и в отношении «вампиров времени», которые «слишком много говорят на совещаниях» или «слишком много печатают». [and] не умеют сжимать свои мысли», отметив, что когда таких людей больше нет в компании, «совещание занимает 20 минут, а мы успеваем сделать в пять раз больше».

Ничипорчик считает, что сочетание искусственного интеллекта с традиционными HR-инструментами может позволить игровым студиям «выявить человека, который находится на грани выгорания, который может быть причиной выгорания коллег, работающих с этим человеком», а затем устранить проблему до того, как она станет реальной проблемой. Он признал антиутопичность этой идеи, назвав ее «очень похожей на «Черное зеркало», но добавил, что «это работает», и предположил, что студия уже использовала эту систему для выявления руководителя студии, который «был не в лучшем положении».

«Если бы мы ждали месяц, то, возможно, у нас не было бы студии», — сказал Ничипорчик. «Поэтому я очень рад, что это сработало».

Предсказуемо, что практически все, кто прочитал комментарии Ничипорчика, остались недовольны: Мысль о том, что за тобой следят машины, которые могут лишить тебя работы из-за того, что ты нарушил какое-то неизвестное правило, запрещающее много говорить, — это полный бред из «Отчета о положении дел в стране меньшинств». Однако в комментариях, присланных в редакцию , Ничипорчик заявил, что описанные им системы являются гипотетическими и не используются в Tinybuild, и что смысл его выступления заключался в том, чтобы противопоставить «оптимистический» взгляд на инструменты ИИ как способ ускорения процессов и «антиутопический».

«Мы наблюдаем слишком много случаев кризиса и выгорания в отрасли, а при удаленной работе вы часто не можете определить, где находится человек. Как у них на самом деле обстоят дела?» сказал Ничипорчик. «В примере с I/ME — это то, что я начал использовать пару лет назад, просто как наблюдение на совещаниях. Обычно это означало, что человек недостаточно уверен в своих результатах на работе и просто нуждается в дополнительной обратной связи и подтверждении того, что он хорошо справляется со своими обязанностями, или в действиях по улучшению ситуации».

(Image credit: Alex Nichiporchik (Twitter))

Ничипорчик признал, что слайд с «вампиром времени», который он использовал в презентации, был «ужасен в контексте этой дискуссии», но сказал, что, по его мнению, такое поведение также может указывать на выгорание. Его смешение понятий «выгорание» и «токсичность», продолжил он, было призвано показать, что токсичное поведение часто является лишь проявлением проблем, с которыми люди сталкиваются на работе, и что эти проблемы в конечном итоге могут привести к выгоранию.

«Выгорание может быть причиной токсичности, и если его предотвратить, то рабочая среда будет намного лучше», — сказал он. «[Toxicity] может возникнуть в условиях, когда люди не чувствуют, что их ценят, или не получают достаточной обратной связи по поводу своей работы. Пребывание в таком состоянии может привести к выгоранию. Большинство людей думают, что выгорание — это результат «хруста», но дело не только в этом. Речь идет о том, чтобы работать с людьми, которые вам нравятся, и знать, что вы приносите пользу. Без позитивной атмосферы легко перегореть. Особенно в командах, где люди, возможно, даже не встречались в реальной жизни и не установили уровень доверия, выходящий за рамки чата и виртуальных встреч».

Что касается руководителя студии, о котором шла речь в презентации, то Ничипорчик сказал, что компания использовала «принцип, описанный в презентации», а не реальный искусственный интеллект, чтобы определить, что моральный дух в команде разработчиков страдает из-за того, что сотрудник перегружен работой. Сотрудник не был уволен, но сейчас он находится в «длительном отпуске», а по возвращении перейдет на новый проект.

(Image credit: Tinybuild (Twitter))

Вся эта ситуация еще раз демонстрирует, что тема искусственного интеллекта, мягко говоря, щекотлива: гипотетическая она или нет, но людей вполне обоснованно пугает мысль о том, что все, что они говорят, анализируется системами машинного обучения, позволяющими угадать их душевное состояние или возможности. В свою очередь, Ничипорчик утверждает, что системы искусственного интеллекта, напоминающие «Черное зеркало», о которых он рассказал в своей презентации, Tinybuild никогда не будет использовать.

«Мы не будем», — сказал он, когда я спросил его, как Tinybuild собирается внедрять искусственный интеллект в свои кадровые ресурсы. «Мы не используем ни один из этих инструментов для работы с персоналом. Я бы не хотел работать в компании, которая этим занимается».

Ничипорчик сообщил в Twitter, что видеозапись его выступления будет в определенный момент выложена на YouTube, и ее можно будет увидеть целиком. Мы сообщим, когда она будет доступна.